3D 立體影像感測技術

數位相機只能取得平面彩色影像,完全沒有深度的資訊,這代表當我們看到一張照片,只知道這個人的臉部有多寬多高,卻不知道他臉部的立體結構,例如:鼻子有多挺(有多深),為了取得影像的深度資訊,近年來許多廠商投入研發,目前比較成熟的技術有下列兩種:

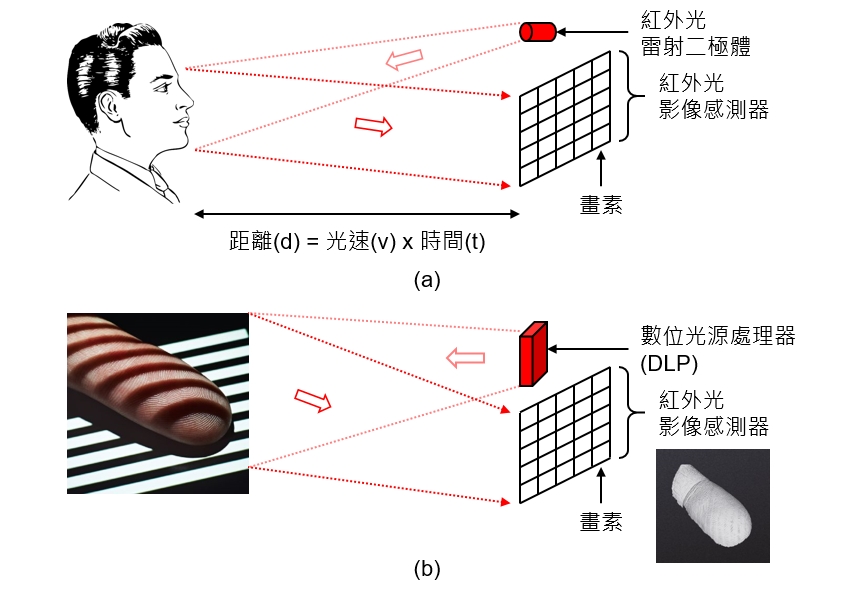

➤ 飛時測距 (ToF:Time of Flight):利用發光二極體(LED:Light Emitting Diode)或雷射二極體(LD:Laser Diode)發射出紅外光,照射到物體表面反射回來,由於光速(v)已知,可以利用一個紅外光影像感測器量測物體不同深度的位置反射回來的時間(t),利用簡單的數學公式就可以計算出物體不同位置的距離(深度),如<圖一(a)>所示。

➤ 結構光(Structured light):利用雷射二極體(LD:Laser Diode)或數位光源處理器(DLP:Digital Light Processor)打出不同的光線圖形,經由物體不同深度的位置反射回來會造成光線圖形扭曲,例如:打出直線條紋的光線到手指上,由於手指是立體圓弧形造成反射回來變成圓弧形條紋,進入紅外光影像感測器後就可以利用圓弧形條紋反推手指的立體結構,如<圖一(b)>所示。

圖一、3D 立體影像感測技術原理示意圖。

資料來源:home.lagoa.com/2014/04/whats-the-right-3d-scanner-for-you。

TrueDepth 相機

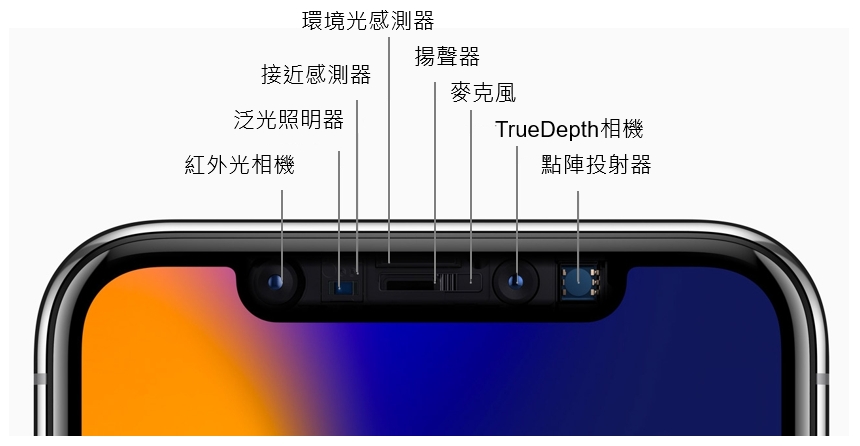

蘋果(Apple, AAPL-US)將 iPhone X 所使用的 3D 立體影像感測技術稱為「TrueDepth相機」,結合了前面介紹的兩種技術,如<圖二>所示,TrueDepth 相機為 700 萬畫素的 CMOS 影像感測器,配合紅外光相機(Infrared camera)、泛光照明器(Flood illuminator)、接近感測器(Proximity sensor)、環境光感測器(Ambient light sensor)、點陣投射器(Dot projector)等元件,以下簡單介紹每個元件的功能:

➤泛光照明器(Flood illuminator):使用「低功率」的垂直共振腔面射型雷射(VCSEL:Vertical Cavity Surface Emitting Laser),發射出「非結構(Non-structured)」的紅外光投射在物體表面。

➤接近感測器(Proximity sensor):使用「低功率」的垂直共振腔面射型雷射(VCSEL)發射紅外光雷射,當有物體靠近時會反射雷射光,因此手機可以知道有物體接近,這個元件很早之前智慧型手機就有了,一般都是安裝在擴音器(Speaker)旁邊,但是以前通常是使用紅外光發光二極體(IR LED),可以偵測的距離較短,當使用者撥電話並且將手機靠近耳朵時,接近感測器偵測到耳朵接近就知道使用者正要講電話,會自動關閉螢幕節省電力消耗。

➤環境光感測器(Ambient light sensor):使用光感測器(PD:Photo Detector)可以偵測環境光亮度,在明亮的太陽下使用者眼睛瞳孔縮小,因此自動將螢幕調亮讓使用者容易觀看;在陰暗的室內使用者眼睛瞳孔放大,因此自動將螢幕調暗避免使用者感覺太刺眼。

➤點陣投射器(Dot projector):使用「高功率」的垂直共振腔面射型雷射(VCSEL)發射紅外光雷射,經由晶圓級光學(WLO:Wafer Level Optics)、繞射光學元件(DOE:Diffractive Optical Elements)等結構,產生大約 3 萬個「結構(Structured)」光點投射到使用者的臉部,利用這些光點所形成的陣列反射回紅外光相機(Infrared camera),可以計算出臉部不同位置的距離(深度)。

圖二、iPhone X 所使用的 3D 立體影像感測技術。

資料來源:蘋果官網

Face ID 解鎖原理與步驟

Face ID 解鎖主要分為兩個步驟,首先必須辨識接近手機的是否為刻意靠近的臉部,或者只是使用者不小心由手機前面晃過去而已;確認是刻意靠近的臉部之後,才開始進行人臉辨識,從前面的介紹可以發現,啟動 Face ID 解鎖必須同時開啟好幾個元件,是有些耗電的,因此必須確認是刻意靠近的臉部之後,才開始進行人臉辨識。

當有臉部或物體靠近時,會先啟動接近感測器(Proximity sensor),再由接近感測器發出訊號啟動泛光照明器(Flood illuminator),發射出非結構(Non-structured)的紅外光投射在物體表面,再由紅外光相機(Infrared camera)接收這些反射的影像資訊,傳送到手機內的處理器,iPhone X 使用蘋果自行開發的 A11 處理器,內建雙核心的「神經網路引擎(NE:Neural Engine)」,經由人工智慧的運算後判斷為臉部,再啟動點陣投射器(Dot projector) 產生大約 3 萬個光點投射到使用者的臉部形成「結構光(Structured light)」,利用這些光點所形成的陣列反射回紅外光相機(Infrared camera),經由這些光點的偏移計算出臉部不同位置的距離(深度),再將這些使用者臉部的深度資訊傳送到處理器,經由計算比對臉部特徵辨識是否為使用者本人。

所有的 3D 立體影像感測技術都面臨相同的問題,那就是深度資訊的精確度實際值大約只有 1%~0.1%,意思是距離 1 公尺遠的物體量測出來的精確度與誤差大約是 1~10 毫米的等級,Face ID 解鎖時臉部與手機的距離大約 0.1 公尺,因此精確度與誤差大約是 0.1~1 毫米的等級,這大概足夠進行臉部特徵辨識了!此外,點陣投射器(Dot projector)使用高功率的垂直共振腔面射型雷射(VCSEL)發射紅外光雷射,雖然它的功率並不是真的很高,但是長期入射到眼睛是否會造成眼球的傷害,是另外一個值得醫學界研究探討的問題。

人工智慧的雲端與終端

人工智慧(AI:Artificial Intelligence)大量的學習與運算目前都借助於雲端伺服器強大的處理器來進行,早期使用 Intel(INTC-US)的「中央處理器(CPU:Central Processing Unit)」,後來科學家發現 Nvidia(NVDA-US)的「圖形處理器(GPU:Graphics Processing Unit)」效能比 CPU 高 100 倍以上,Intel 經由併購 Altera 取得「可程式化邏輯陣列(FPGA:Field Programmable Gate Array)」技術來與 GPU 抗衡。

另外有更多的廠商開發始發展「特定應用積體電路(ASIC:Application Specific Integrated Circuit)」,例如:Google(GOOGL-US)自行設計的「張量處理器(TPU:Tensor Processing Unit)」或 Intel 自行設計的「視覺處理器(VPU:Vision Processing Unit)」,就是一種針對人工智慧這種「特定應用」所開發的積體電路,以上這些處理器都是裝置在「雲端(Cloud side)」。然而並不是所有的應用都適合把大數據傳送到雲端處理,例如:自動駕駛車必須在車上「終端(Edge side)」進行學習與處理才能即時反應道路情況。

蘋果公司這次推出的 iPhone X 使用自行開發的 A11 處理器,內建雙核心的「神經網路引擎(NE:Neural Engine)」,專門處理影像辨識相關的機器學習、推論模型、演算法,也是一種針對人工智慧這種「特定應用」所開發的積體電路,不同的是它裝置在「終端(Edge side)」,也就是使用者的手機上,讓手機可以認識使用者的臉部特徵,蘋果公司也一再強調,使用者所有的臉部特徵都在手機終端完成,不會上傳到雲端處理,因此絕對不會有資料外洩的疑慮。

蘋果公司這次發表的 iPhone X 讓使用者能夠真實感受終端裝置的人工智慧(On-device AI),在可以預見的未來,終端的處理器如何與人工智慧結合形成「終端智能(Edge intelligence)」,將是愈來愈熱門的議題。

【請注意】上述內容經過適當簡化以適合大眾閱讀,與產業現狀可能會有差異,若您是這個領域的專家想要提供意見,請自行聯絡作者;若有產業與技術問題請參與社群討論。

《知識力》授權轉載

【延伸閱讀】

全球CMOS影像感測器的領導廠商.png)