編按:股感認為,NVIDIA GTC 是 CES 演講的延伸,在這次提供更多產品的細節,例如:

- 推出了兩個 CPO Switch 產品 Quantum-X /Spectrum-X,將預計分別在在 2025H2/2026H1 中採用。

- 強調 Reasoning 需要的算力更高以及 Blackwell 在 Inference 也同樣具有優勢

- 展示全新的 Blackwell 晶片代號為「Ultra」,也就是 GB300 AI 晶片,接棒去年的「全球最強 AI 晶片」 B200 ,再一次實現性能上的突破。(延伸閱讀:GB300 深度解析!GB300 概念股介紹)

- NVIDIA 在產品路線圖中強調 Rubin GPU。根據我們的管道檢查,下一代 Rubin GPU 晶片預計將於 5 月在台積電(Tape-Out),樣品將於今年 9 月交付給下游客戶。

- GPU Roadmap 往後推進到2028年的 Feynman ,但要討論 Feynman 還太早,現在 Rubin 都還沒有定案。

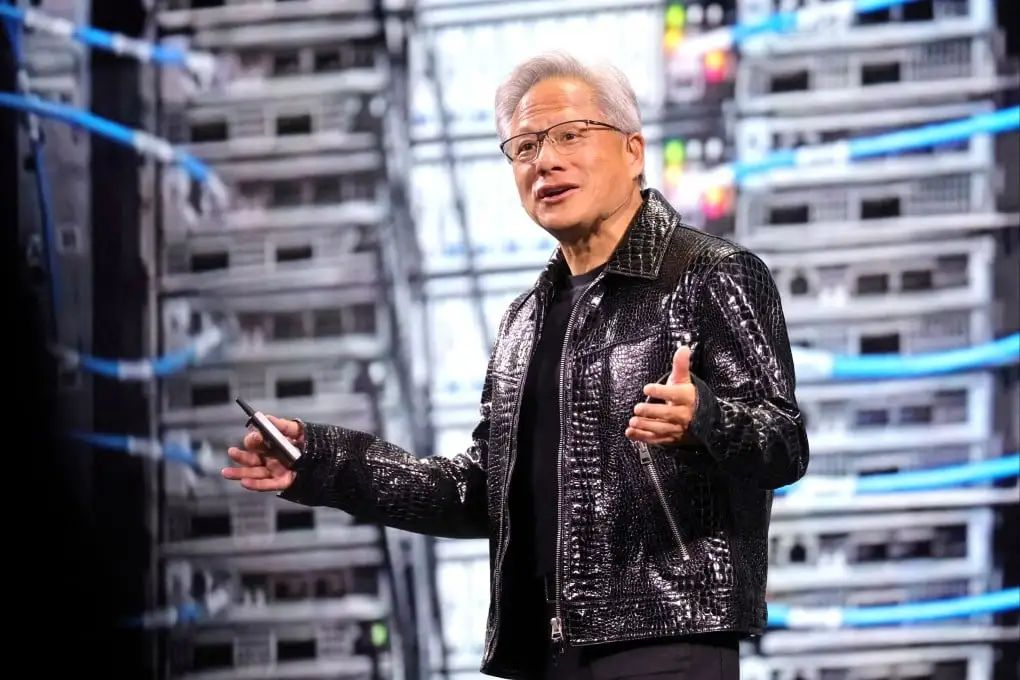

輝達(NVIDIA, NVDA-US) GTC 大會已經成了 AI 界超級碗,沒有劇本也沒有提詞器,中途黃仁勳被線纜卡住,反而是這場高濃度 AI 發表會里最有人味的片段,在當今提前基本提前彩排或錄播的科技發表會里已經很稀缺了。

剛剛,黃仁勳再次發布了全新一代核彈級 AI 晶片,不過這場發表會的還有個隱藏主角——DeepSeek。

由於 Agentic AI 和推理能力的提升,現在所需的計算量至少是去年此時預估的 100 倍。

推理成本效率給 AI 產業帶來影響,而不是簡單地堆積計算能力,成為貫穿這場發表會的主線。輝達要變成 AI 工廠,讓 AI 以超越人類的速度學習和推理。

推理本質上是一座工廠在生產 token,而工廠的價值取決於能否創造收入和利潤。因此,這座工廠必須以極致的效率打造。

黃仁勳掏出的輝達新「核彈」也在告訴我們,未來的人工智慧競爭不在於誰的模型更大,而在於誰的模型具有最低的推理成本和更高推理的效率。

除了全新 Blackwell 晶片,還有兩款「真·AI PC」

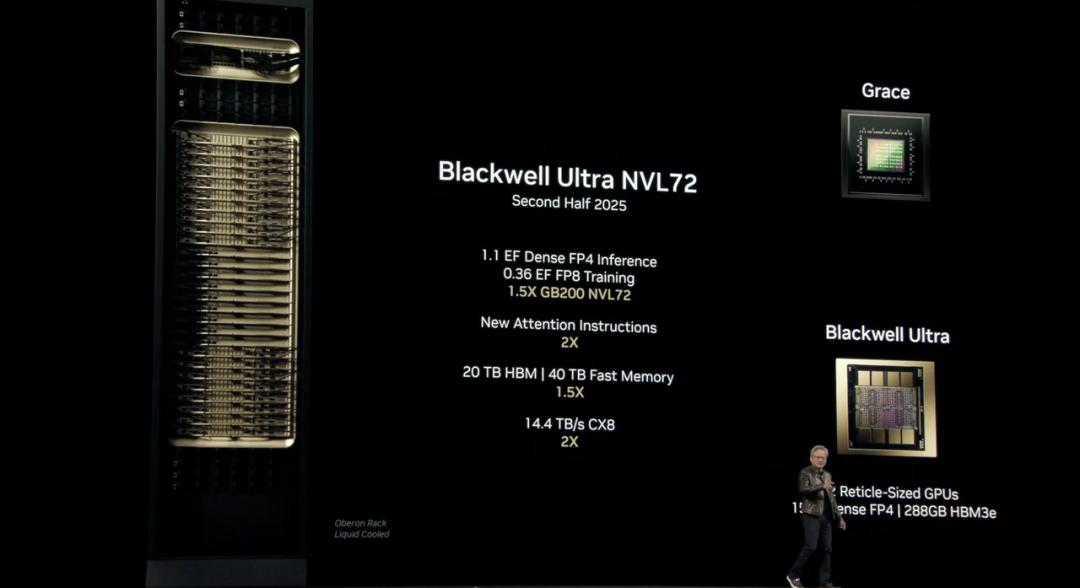

全新的 Blackwell 晶片代號為「Ultra」,也就是 GB300 AI 晶片,接棒去年的「全球最強 AI 晶片」 B200 ,再一次實現性能上的突破。

Blackwell Ultra 將包括輝達 GB300 NVL72 機架級解決方案,以及輝達 HGX B300 NVL16 系統。

Blackwell Ultra GB300 NVL72 將於今年下半年發布,參數細節如下:

- 1.1 EF FP4 Inference:在進行 FP4 精度的推理任務時,能夠達到 1.1 ExaFLOPS(每秒百億億次浮點運算)。

- 0.36 EF FP8 Training:在進行 FP8 精度的訓練任務時,性能為 1.2 ExaFLOPS。

- 1.5X GB300 NVL72 :與 GB200 NVL72 相比,性能為 1.5 倍。

- 20 TB HBM3 :配備了 20TB HBM 內處理器,是前代的 1.5 倍

- 40 TB Fast Memory:擁有 40TB 的快速內處理器,是前代的 1.5 倍。

- 14.4 TB/s CX8 :支持 CX8 ,頻寬為 14.4 TB/s,是前代的 2 倍。

單個 Blackwell Ultra 晶片將和前代一樣提供相同的 20 petaflops(每秒千兆次浮點運算) AI 性能,但配備更多的 288GB 的 HBM3e 內處理器。

如果說 H100 更適合大規模模型訓練, B200 在推理任務中表現出色,那麽 B300 則是一個多功能平台,預訓練、後訓練和 AI 推理都不在話下。

輝達還特別指出,Blackwell Ultra 也適用於 AI 智能體,以及用於訓練機器人和汽車自動駕駛的「物理 AI」。

為了進一步增強系統性能,Blackwell Ultra 還將與輝達的 Spectrum-X 以太網和輝達 Quantum- X800 InfiniBand 平台集成,為系統中的每個 GPU 提供 800Gb /s 的數量頻寬,幫助 AI 工廠和雲數據中心能夠更快處理 AI 推理模型。

除了 NVL72 機架,輝達還推出了包含單個 GB300 Blackwell Ultra 晶片的台式電腦 DGX Station。Blackwell Ultra 之外,這個主機還將配備 784GB 的同一系統內處理器,內置 800Gbps 輝達 ConnectX- 8 SuperNIC 網路,能夠支持 20 petaflops 的 AI 性能。

而之前在 CES 2025 展示的「迷你主機」Project DIGITS 也正式被命名為 DGX Spark,搭載專為桌面優化的 GB10 Grace Blackwell 超級晶片,每秒可提供高達 1000 兆次 AI 計算操作,用於最新 AI 推理模型的微調和推理,包括 NVIDIA Cosmos Reason 世界基礎模型和 NVIDIA GR00T N1 機器人基礎模型。

黃仁勳表示,借助 DGX Station 和 DGX Spark,用戶可以在當地運作大模型,或者將其部署在 NVIDIA DGX Cloud 等其他加速雲或者數據中心基礎設施上。

這是 AI 時代的電腦。

DGX Spark 系統現已開放預訂,而 DGX Station 預計將由華碩、戴爾(Dell, DELL-US)、惠普(HP Company, HPQ-US)等合作夥伴於今年晚些時候推出。

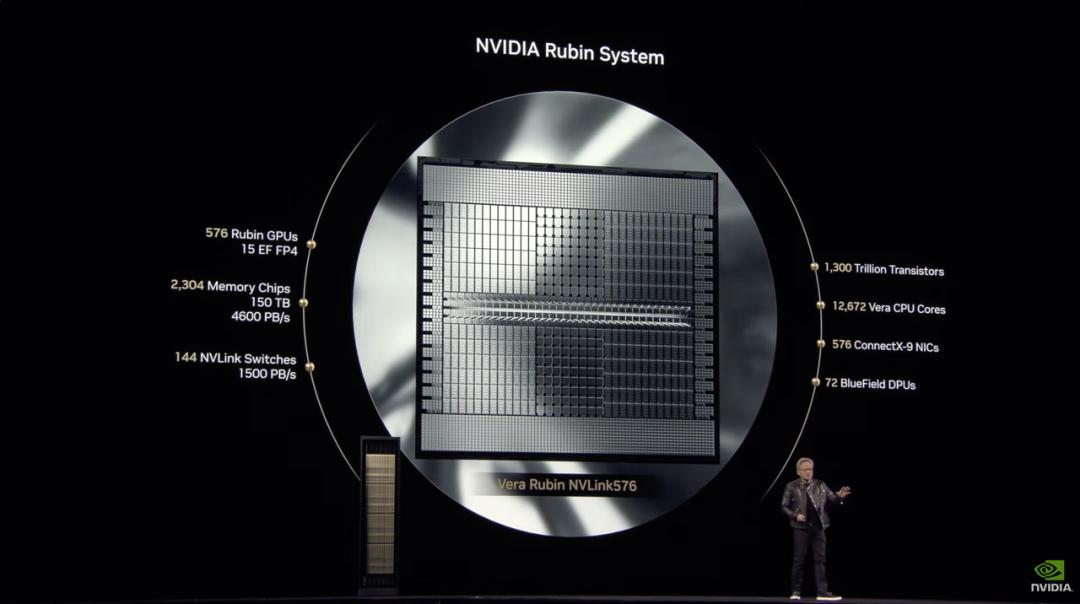

下一代 AI 晶片 Rubin 官宣, 2026 年下半年推出

輝達一直以科學家的名字為其架構命名,這種命名方式已成為輝達文化的一部分。這一次,輝達延續了這一慣例,將下一代 AI 晶片平台命名為「Vera Rubin」,以紀念美國著名天文學家薇拉·魯賓(Vera Rubin)。

黃仁勳表示,Rubin 的性能將達到 Hopper 的 900 倍,而 Blackwell 相較 Hopper 已實現了 68 倍的提升。

其中,Vera Rubin NVL144 預計將在 2026 年下半年發布。規格資訊如下:

- 3.6 EF FP4 Inference:在進行 FP4 精度的推理任務時,能夠達到 3.6 ExaFLOPS(每秒百億億次浮點運算)。

- 1.2 EF FP8 Training:在進行 FP8 精度的訓練任務時,性能為 1.2 ExaFLOPS。

- 3.3X GB300 NVL72 :與 GB300 NVL72 相比,性能提升了 3.3 倍。

- 13 TB/s HBM4 :配備了 HBM4 ,頻寬為 13TB /s。

- 75 TB Fast Memory:擁有 75 TB 的快速內處理器,是前代的 1.6 倍。

- 260 TB/s NVLink6 :支持 NVLink 6 ,頻寬為 260 TB/s,是前代的 2 倍。

- 28.8 TB/s CX9 :支持 CX9 ,頻寬為 28.8 TB/s,是前代的 2 倍。

標準版 Rubin 將配備 HBM4 ,性能比目前的 Hopper H100 晶片大幅提升。

Rubin 引入名為 Grace CPU 的繼任者——Veru,包含 88 個定制的 Arm 核心,每個核心支持 176 個線程,並通過 NVLink- C2C 實現 1.8 TB/s 的高頻寬連接。

輝達表示,定制的 Vera 設計將比去年 Grace Blackwell 晶片中使用的 CPU 速度提升一倍。

與 Vera CPU 搭配時,Rubin 在推理任務中的算力可達 50 petaflops,是 Blackwell 20 petaflops 的兩倍以上。此外,Rubin 還支持高達 288GB 的 HBM4 內處理器,這也是 AI 開發者關注的核心規格之一。

實際上,Rubin 由兩個 GPU 組成,而這一設計理念與目前市場上的 Blackwell GPU 類似——後者也是通過將兩個獨立晶片組裝為一個整體運作。

從 Rubin 開始,輝達將不再像對待 Blackwell 那樣把多 GPU 組件稱為單一 GPU,而是更準確地按照實際的 GPU 晶片裸片數量來計數。

互聯技術也升級了,Rubin 配備第六代 NVLink,以及支持 1600 Gb/s 的 CX9 網卡,能夠加速數據傳輸並提升連接性。

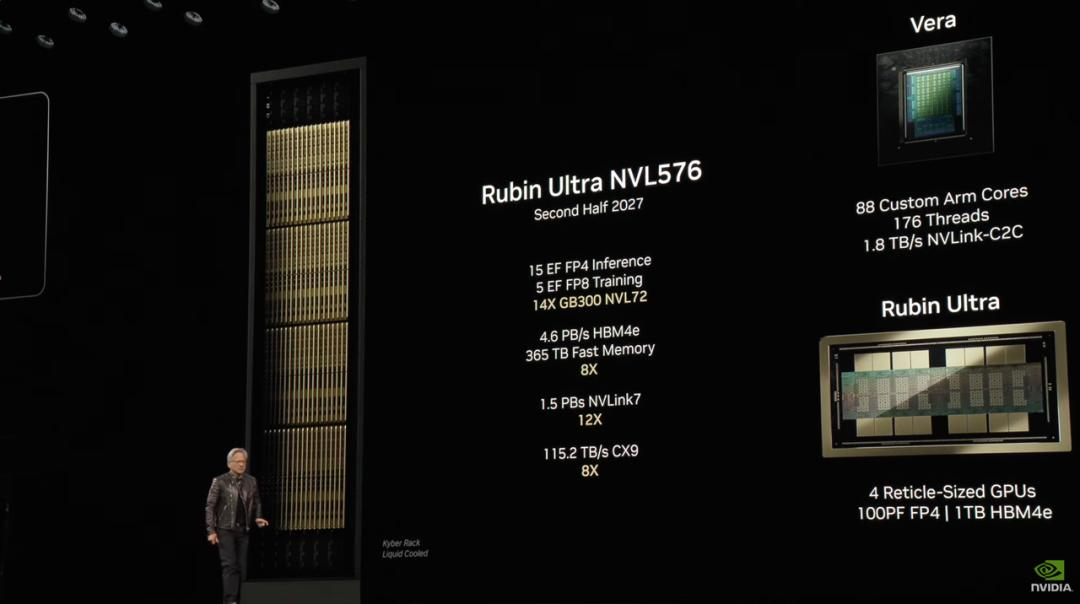

除了標準版 Rubin,輝達還計劃推出 Rubin Ultra 版本。

Rubin Ultra NVL576 則將於 2027 年下半年推出。參數細節如下:

- 15 EF FP4 Inference:在 FP4 精度下進行推理任務時,性能達到 15 ExaFLOPS。

- 5 EF FP8 Training:在 FP8 精度下進行訓練任務時,性能為 5 ExaFLOPS。

- 14X GB300 NVL72 :相比 GB300 NVL72 ,性能提升 14 倍。

- 4.6 PB/s HBM4e :配備 HBM4e 內處理器,頻寬為 4.6 PB/s。

- 365 TB Fast Memory:系統擁有 365 TB 的快速內處理器,是前代的 8 倍。

- 1.5 PB/s NVLink7 :支持 NVLink 7 ,頻寬為 1.5 PB/s,是前代的 12 倍。

- 115.2 TB/s CX9 :支持 CX9 ,頻寬為 115.2 TB/s,是前代的 8 倍。

在硬體配置上,Rubin Ultra 的 Veras 系統延續了 88 個定制 Arm 核心的設計,每個核心支持 176 個線程,並通過 NVLink- C2C 提供 1.8 TB/s 的頻寬。

而 GPU 方面,Rubin Ultra 集成了 4 個 Reticle-Sized GPU,每顆 GPU 提供 100 petaflops 的 FP4 計算能力,並配備 1TB 的 HBM4e 內處理器,在性能和內處理器容量上都達到了新的高度。

為了在瞬息萬變的市場競爭中站穩腳跟,輝達的產品發布節奏已經縮短至一年一更。發表會上,老黃也正式揭曉下一代 AI 晶片的命名——物理學家費曼(Feynman)。

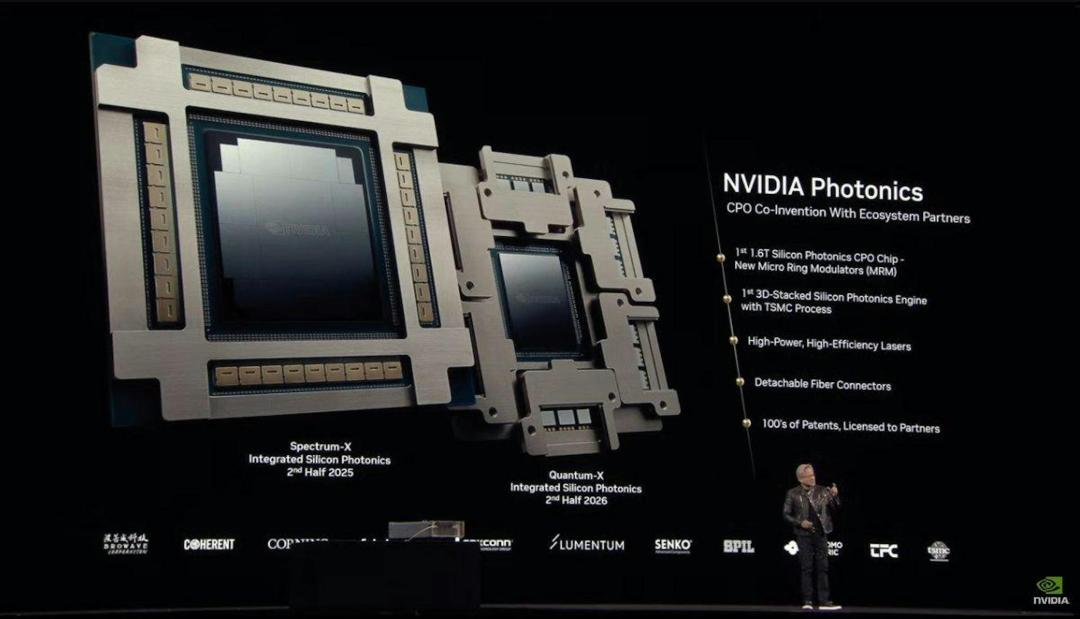

隨著 AI 工廠的規模不斷擴大,網路基礎設施的重要性愈發凸顯。

為此,輝達推出了 Spectrum-X™ 和 Quantum-X 矽光網路交換機,旨在幫助 AI 工廠實現跨站點連接數百萬 GPU,同時顯著降低能耗和營運成本。

Spectrum-X Photonics 交換機具有多種配置,包括:

- 128 端口 800Gb /s或 512 端口 200Gb /s 配置,總頻寬達 100Tb /s

- 512 端口 800Gb /s或 2048 端口 200Gb /s配置,總頻寬達 400Tb /s

與之配套的 Quantum-X Photonics 交換機則基於 200Gb /s SerDes 技術,提供 144 端口 800Gb /s 的 InfiniBand 連接,並採用液冷設計高效冷卻板載矽光子組件

與上一代產品相比,Quantum-X Photonics 交換機為 AI 計算架構提供 2 倍速度和 5 倍可擴展性。

Quantum-X Photonics InfiniBand 交換機預計於今年晚些時候上市,而 Spectrum-X Photonics 以太網交換機預計將於 2026 年推出。

隨著 AI 的快速發展,對數據中心的頻寬、低延遲和高能效需求也急劇增加。

輝達 Spectrum-X Photonics 交換機採用了一種名為 CPO 的光電子集成技術。其核心是將光引擎(就是能處理光訊號的晶片)和普通的電子晶片(比如交換晶片或 ASIC 晶片)放在同一個封裝里。

這種技術的好處很多:

- 傳輸效率更高:因為距離縮短,訊號傳輸更快。

- 功耗更低:距離短了,傳輸訊號需要的能量也少了。

- 體積更小:把光和電的零件集成在一起,整體體積也變小了,空間利用率更高。

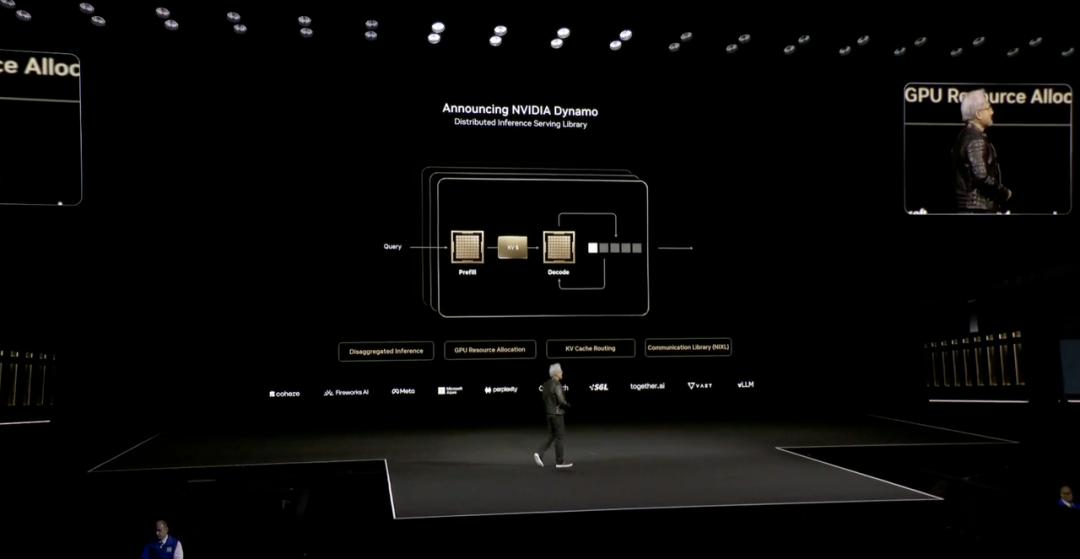

AI 工廠的「操作系統」Dynamo

未來將沒有數據中心,只有 AI 工廠。

黃仁勳表示,未來,每個產業、每家公司擁有工廠時,都將有兩個工廠:一個是他們實際生產的工廠,另一個是 AI 工廠,而 Dynamo 則是專門為「AI 工廠」打造的操作系統。

Dynamo 是一款分布式推理服務庫,為需要 token 但又無法獲得足夠 token 的問題提供開源解決方案。

簡單來說,Dynamo 有四個方面的優勢:

- GPU 規劃引擎,動態調度 GPU 資源以適應用戶需求

- 智能路由器,減少 GPU 對重複和重疊請求的重新計算,釋放更多算力應對新的傳入請求

- 低延遲通訊庫,加速數據傳輸

- 內處理器管理器,智能在低成本內處理器和儲存設備中的推理數據

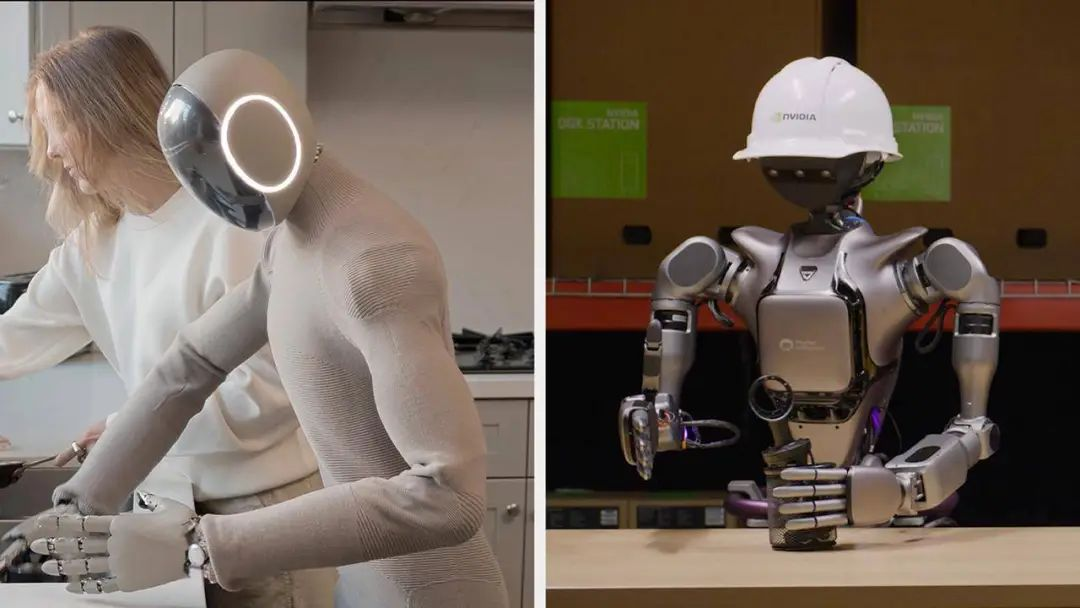

人形機器人的露臉環節,永遠不會缺席

人形機器人再一次成為了 GTC 大會的壓軸節目,這次輝達帶來了 Isaac GR00T N1 ,全球首款開源人形機器人功能模型。

黃仁勳表示,通用機器人技術的時代已經到來,借助 Isaac GR00T N1 核心的數據產生以及機器人學習框架,全球各地的機器人開發人員將進入 AI 時代的下一個前端領域。

這個模型採用「雙系統」架構,模仿人類的認知原理:

- 系統 1 :快速思考的動作模型,模仿人類的反應或直覺

- 系統 2 :慢思考的模型,用於深思熟慮的決策

在視覺語言模型的支持下,系統 2 對環境和指令進行推理,然後規劃動作,系統 1 將這些規劃轉化為機器人的的動作。

GR00T N1 的基礎模型採用廣義類人推理和技能進行了預訓練,而開發人員可以通過真實或合成數據進行後訓練,滿足特定的需求:既可以完成工廠的特定任務,也可以在家裡自主完成家務。

黃仁勳還宣布了與 Google DeepMind 和 Disney Research 合作開發的開源物理引擎 Newton。

一台搭載 Newton 平台的機器人也登上了舞台,黃仁勳稱之為「Blue」,外觀神似《星球大戰》中的 BDX 機器人,能夠用聲音和動作和黃仁勳互動。

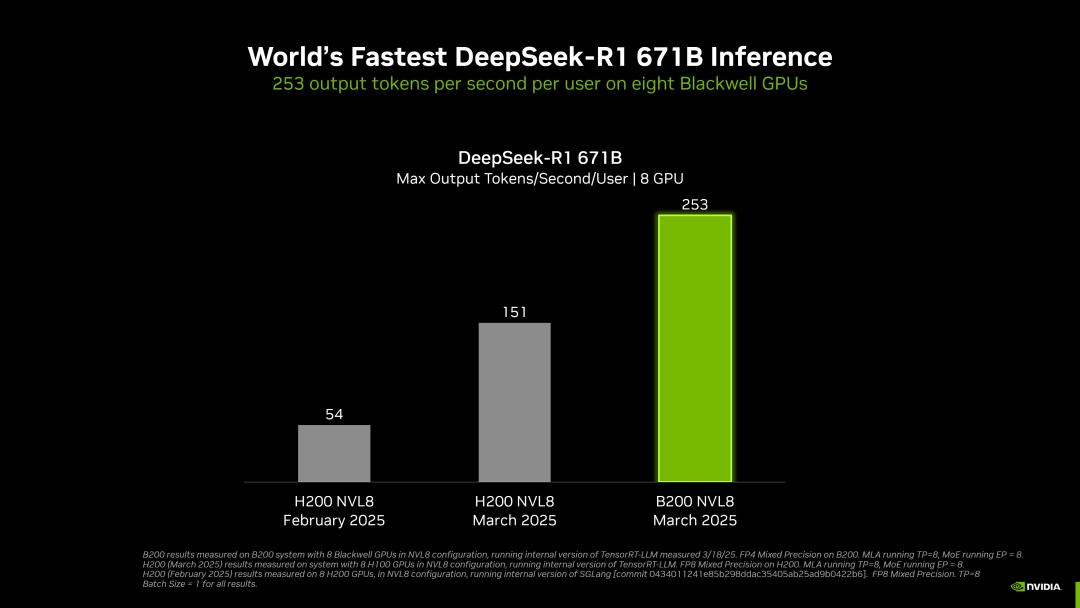

8 塊 GPU,DeepSeek- R1 推理速度創全球之最

輝達實現了全球最快的 DeepSeek- R1 推理。

官網顯示,一台搭載 8 個 Blackwell GPU 的 DGX 系統,在運作 6710 億參數的 DeepSeek- R1 模型時,可實現每用戶每秒超過 250 個 token 的速度,或達到最高頻寬每秒超過 30,000 個 token。

通經得起考驗體和軟體的結合,自今年 1 月以來,輝達在 DeepSeek- R1 671B 模型上的頻寬提升了約 36 倍,每 token 的成本效率提高了約 32 倍。

為了實現這一成就,輝達完整的推理生態系統已針對 Blackwell 架構進行了深度優化,不僅整合 TensorRT-LLM、TensorRT Model Optimizer 等先進工具,還無縫支持 PyTorch、JAX 和 TensorFlow 等主流框架。

在 DeepSeek- R1 、Llama 3.1 405B 和 Llama 3.3 70B 等模型上,採用 FP4 精度的 DGX B200 平台相較於 DGX H200 平台,推理頻寬提升超過 3 倍。

值得注意的是,此次發表會的主題演講並未提及量子計算,但輝達特意在這屆 GTC 大會設置了量子日,邀請了多家當紅量子計算公司的 CEO 出席。

要知道黃仁勳年初一句「量子計算還需 20 年才實用」的論斷猶在耳畔。

一改口風的背後,離不開微軟(Microsoft, MSFT-US)耗時 17 年研發的拓撲量子晶片 Majorana 1 實現 8 個拓撲量子比特集成,離不開 Google Willow 晶片宣稱用 5 分鐘完成經典電腦需 10 ^25 年處理的任務,推動了量子計算的熱潮。

晶片無疑是重頭戲,但一些軟體的亮相同樣值得關注。

矽谷著名投資人馬克·安德森曾提出軟體正在吞噬世界(Software is eating the world)的論斷,其核心邏輯在於軟體通過虛擬化、抽象化和標準化,正在成為控制物理世界的基礎設施。

不滿足於做「賣鏟人」,輝達的野心是打造 AI 時代的「生產力操作系統」。從汽車智能駕駛,到製造業的數字孿生工廠,這些貫穿整場發表會的案例都是將 GPU 算力轉化為產業生產力的具象化表達。

實際上,無論是發表會上亮相的最新核彈晶片,還是押注戰未來的量子計算,黃仁勳在這場發表會上對 AI 未來發展的洞察和布局,都比當下的技術參數與性能指標更具看點。

在介紹 Blackwell 與 Hopper 架構的對比時,黃仁勳還不忘幽默一把。

他以一個 100MW 工廠的對比數據為例,指出採用 Hopper 架構需要 45,000 顆晶片和 400 個機架,而 Blackwell 架構憑藉更高的效率顯著減少了硬體需求。

於是,黃仁勳那句經典的總結再次拋出,「the more you buy, the more you save」(買得越多,省得越多)。隨後話鋒一轉,他又補充說,「the more you buy, the more you make」(買得越多,賺得越多)。

隨著 AI 領域的重心從訓練轉向推理,輝達更需要證明其軟硬體生態在推理場景的不可替代性。

一方面,Meta、Google 等巨頭自研 AI 晶片,可能分流 GPU 市場需求。

另一方面,輝達最新 AI 晶片的適時亮相,回應如 DeepSeek 的開源模型對 GPU 需求的衝擊,並展示推理領域技術優勢,也是為了對沖市場對訓練需求見頂的擔憂。

最近估值跌至 10 年低位的輝達,比以往任何時候都需要一場酣暢淋漓的勝利。

《36氪》授權轉載

【延伸閱讀】

全球CMOS影像感測器的領導廠商.png)